Romanian rail workers accused of bribery turned to ChatGPT for legal tips

導入

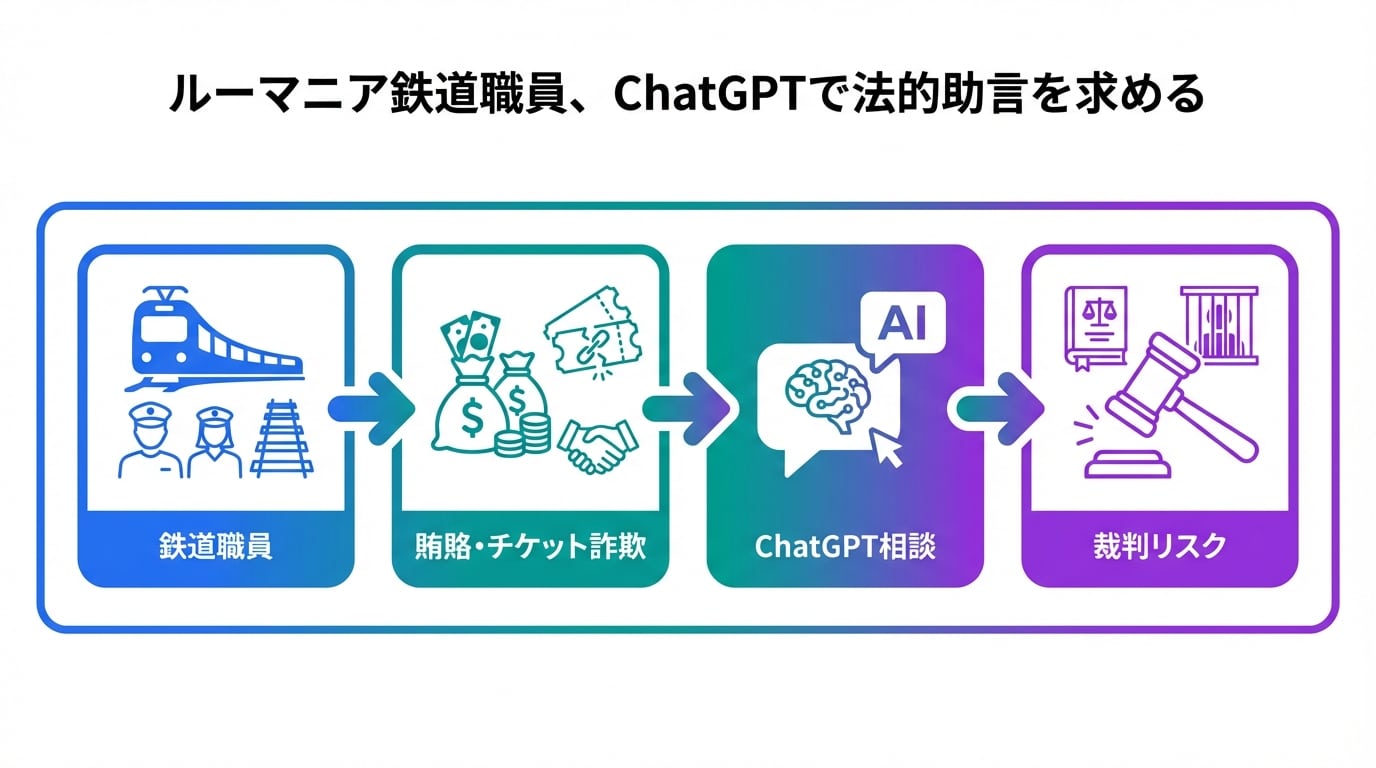

👋 ルーマニアの鉄道職員が賄賂容疑で困った時に、ChatGPTに法的アドバイスを求めたという衝撃のニュース。AIが犯罪の相談相手になる時代が来ました。

ルーマニアの鉄道職員が賄賂の疑いで追及された際、ChatGPTを使って法的アドバイスを得ようとした。

これはAIの日常利用が急速に広がる中、法的な場面での信頼性を問う出来事です。

この記事を読むと、AIの限界を理解し、ビジネスや日常で安全に活用する判断力が身につきます。

職場でトラブルが起きた時、誰しも素早く解決策を探したくなるもの。ところが、AIに頼る人が増え、予期せぬリスクが生じています。このニュースは、そんな現代の「あるある」を象徴しています。

🔰 記事レベル:一般

🎯 こんな人におすすめ:AIを仕事や日常で活用するビジネスパーソン、ニュースから社会の変化を読み取りたい人、AIのリスクを知り安全に使いたい人

✅ まず押さえる3点

- ルーマニア鉄道職員が賄賂容疑でChatGPTに法的助言を求めた事件の詳細

- AIの法的アドバイスがもたらす危険性と社会的影響

- AIを正しく活用するための実践的な心構え

このニュース、社会のAI依存をどう変えるのか、次で詳しく見ていきましょう。

背景と課題

ルーマニアの鉄道職員が賄賂の疑いをかけられた背景には、日常業務での汚職問題があります。

彼らは捜査当局から事情聴取を受け、追い詰められた末にChatGPTに相談したのです。

これは、AIが手軽にアクセスできるツールとして普及した結果、専門外の分野でも頼られるケースが増えている証拠です。

例えば、職場で契約トラブルが起きた時、「とりあえずChatGPTで聞いてみよう」と考える人が急増中です。

しかし、AIは法的知識の専門家ではなく、誤った情報を出力する可能性が高いのが課題です。

- 法的アドバイスは国ごとの法律に依存するため、グローバルなAIが正確に扱えない

- 緊急時の判断ミスが深刻な結果を招くリスク

- AI依存が専門家の相談を怠らせる問題

このような課題が、ニュースの核心に迫ります。次は事件の詳細を深掘り。

技術・内容解説

事件の核心は、鉄道職員がChatGPTに「賄賂容疑の対処法」を尋ね、AIが具体的なアドバイスを出した点です。

詳細は元ニュース記事で確認できます。

AIの応答は一般論に基づくもので、法的責任を免れるものではありませんでした。

| 項目 | 従来 | 今回 |

|---|---|---|

| 相談の仕方 | 弁護士や専門家に直接相談 | ChatGPTなどのAIに即時相談 |

| アドバイスの信頼性 | 法的責任を伴う専門知識 | 一般知識ベースで誤り含む可能性 |

| リスク | 相談料発生も正確性高い | 無料だが法的ミスで事態悪化 |

- よくある誤解1:AIの回答は法的効力がある → 正しくは娯楽・参考情報として扱い、専門家確認必須

- よくある誤解2:ChatGPTは万能 → 正しくは訓練データ次第で古い・不正確な情報が出力される

- よくある誤解3:無料だから安全 → 正しくは機密情報入力でプライバシー漏洩の恐れあり

AIの技術的限界が事件を招きました。次は用語を整理して理解を深めましょう。

用語解説

- 賄賂

- 業務や判断を有利にするために渡す不正な金品。不正行為の典型例です。

- ChatGPT

- OpenAIが開発した会話型AI。質問に自然言語で答えますが法的専門家ではありません。

- 法的アドバイス

- 法律に基づく具体的な助言。資格者が行うべきもので、AIは代替になりません。

- 鉄道職員

- 公共交通機関の運営・保守を担う人々。今回の事件では汚職疑惑の対象。

- 事情聴取

- 捜査当局が事実確認のために質問すること。容疑者の権利が守られます。

- AI依存

- AIに過度に頼る状態。判断力を弱めるリスクがあります。

- プライバシー漏洩

- 個人情報が不正に公開されること。AI入力時は注意が必要です。

- 専門家相談

- 弁護士などのプロに頼むこと。正確で責任ある解決策が得られます。

- 生成AI

- テキストや画像を自動生成するAI。ChatGPTはその代表例です。

- リスク管理

- 潜在的な危険を予測・回避する仕組み作り。AI活用時の重要ポイント。

用語がクリアになったところで、実際の影響を見てみましょう。

インパクト・活用事例

この事件は、社会全体にAIの法的限界を認識させるインパクトを与えました。

ビジネスでは、コンプライアンス研修でAI利用の注意喚起が増えるでしょう。

期待できることは、AIの娯楽・アイデア出し用途が明確化すること。一方、過度な期待は危なく、法的場面での単独使用は避けるべきです。

- 企業研修:AIのリスク教育が標準化、従業員の誤用防止

- 個人活用:日常の簡単質問に留め、専門相談を優先

- メディア影響:類似事件の報道増加で世論喚起

良い面と悪い面のバランスが鍵。次は具体的な行動策です。

アクションガイド

このニュースから学んだことを即実践しましょう。AIを安全に使うためのステップを提案します。

まずは日常チェックから始め、習慣化してください。

🧾 保存用:確認チェックリスト

⏱ 5分でできる確認

- 今日のAI使用内容をメモ:法的関連か確認

- 入力情報の機密度チェック:個人情報避ける

- 回答の出典確認:信頼できるか見直し

⏳ 15分でできる確認

- 社内ルール確認:AIポリシー文書を読む

- 代替手段リスト作成:専門家連絡先整理

- 類似ニュース検索:「AI 法的誤用」で調べてみる

- 自己テスト:架空質問でAI回答検証

📅 週1で見る指標

- AI使用ログレビュー:誤用パターン探し

- 専門相談件数カウント:依存度測定

- ニュース更新チェック:AI事件関連

これでリスクを最小化。未来の展望へ移ります。

未来展望とリスク

将来的に、AIは法的アドバイス専用ツールとして規制強化される可能性があります。

一方、リスクとして、AIのブラックボックス性が誤情報を増幅する懸念が残ります。

バランスの取れた活用が求められ、企業はAIガバナンスを強化するでしょう。

- 肯定的展望:AI+専門家ハイブリッド相談の普及

- リスク:発展途上国での無規制利用増加

- 対策:国際基準の策定進展

未来は不透明ですが、準備次第。まとめで振り返りましょう。

まとめ

この事件から得た学びを3点に絞ります。

- AIは便利だが法的場面では専門家優先

- 入力情報の慎重管理がプライバシー守る

- ニュースからリスクを学ぶ習慣化

- 次に調べる:自国AI利用規制

- 企業AIポリシー事例

これで全体像がつかめましたね。

💬 あなたは法的トラブル時にAIを頼りますか?体験談をシェアしてください!

参照リンク・情報源

- ルーマニア鉄道職員ChatGPT事件 元記事

- 生成AI 法的リスク で検索して最新事例を確認

- ChatGPT 利用規約 で公式制限事項をチェック

▼ 作業を時短するAIツール(無料枠あり)

無料で使えるAI検索・ファクトチェック

👉 Genspark

おすすめ用途:公開前に事実確認と一次情報の当たりを最短で取る

スライド・企画書の爆速作成(無料お試し可)

👉 Gamma

おすすめ用途:記事の要点をそのままスライド化して配布用に転用する

トレンド記事をショート動画に自動変換(無料トライアル)

👉 Revid.ai

おすすめ用途:記事構成からショート台本と動画素材をまとめて作る

顔出しなしで解説動画を自動生成(無料作成可)

👉 Nolang

おすすめ用途:図解や箇条書きから解説動画を最短で作る

タスクの完全自動化(無料プランからスタート)

👉 Make.com

おすすめ用途:記事公開→SNS投稿→記録→次タスク化 までを自動連携する

※上記リンクにはアフィリエイトが含まれる場合があり、無料枠や仕様は変更される可能性があります(最新情報は公式サイトをご確認ください)。